OpenCV를 사용하여 손 검출 및 인식하기(Hand Detection and Recognition using OpenCV)OpenCV/OpenCV 강좌2019. 9. 24. 22:14

Table of Contents

반응형

OpenCV를 사용하여 손을 검출 및 인식하는 방법에 대해 다룹니다.

현재 두가지 방법으로 코드가 작성되었습니다.

Background Subtraction을 사용한 방법과 HSV 공간에서 살색을 검출한 방법입니다.

다음 에러가 발생하는 경우 아래 포스트를 참고해보세요

The convex hull indices are not monotonous, which can be in the case when the input contour contains self-intersections in function 'cv::convexityDefects

[OpenCV / Python ] convexityDefects 함수에 convex hull indices are not monotonous ... self-intersections 에러 나는 경우 해결 방법

https://webnautes.tistory.com/1432

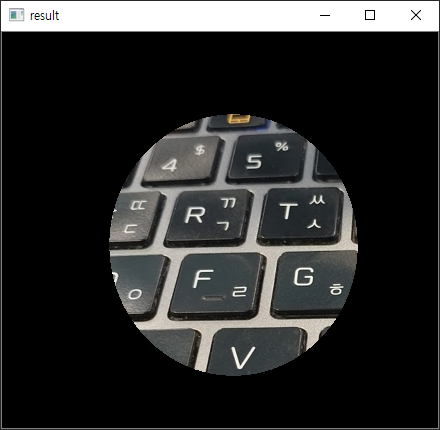

Background Subtraction를 사용한 경우

HSV 색공간에서 살색을 검출한 경우

반응형

'OpenCV > OpenCV 강좌' 카테고리의 다른 글

| OpenCV를 사용하여 바닥에 놓인 트럼프 카드(Playing Card) 인식하기 (6) | 2020.03.18 |

|---|---|

| OpenCV [ WARN:0] terminating async callback 해결 방법 (0) | 2019.10.28 |

| OpenCV를 사용하여 책 검출하기(book detection with OpenCV) (1) | 2019.09.17 |

| OpenCV 강좌 C++ & Python - 컨투어 영역에 텍스쳐 넣기(applying texture in a contour area) (2) | 2019.08.18 |

| OpenCV 강좌 - Camshift 이론과 C++ 예제(Camshift example code in C++) (4) | 2019.07.30 |

![OpenCV [ WARN:0] terminating async callback 해결 방법](https://img1.daumcdn.net/thumb/R750x0/?scode=mtistory2&fname=https%3A%2F%2Ft1.daumcdn.net%2Fcfile%2Ftistory%2F9955C3475DB6E29522)