YoloX 커스텀 학습을 하는 과정을 다루고 있습니다. 최초작성 2025. 4. 10 https://youtu.be/K4gKhxf4u2M

허깅페이스에 있는 Gemma3 4B 모델을 한국어 질문 답변 데이터셋으로 파인튜닝해봤습니다.파인튜닝은 무료 버전 코랩에서 진행했습니다. 코드를 자세히 설명하기보단 진행과정을 어떻게 파인튜닝을 진행하는지 과정만 다루었습니다.사용한 모델과 데이터셋은 다음과 같습니다.사용한 모델 - google/gemma-3-4b-it 사용한 데이터셋 - KorQuAD/squad_kor_v1 https://youtu.be/fvOF5SsFigk

Windows 에 CUDA 11.8과 PyTorch를 설치하는 방법을 설명합니다. 2023. 5. 7 최초작성2023. 9. 92024. 1. 7 별도의 CUDA 없이 설치2024. 3. 16 NVIDIA 그래픽 카드 드라이버 설치 방법 분리 글 업데이트2025. 1. 27 글 업데이트 NVIDIA 그래픽 카드 드라이버 설치다음 포스트를 참고하여 최신 버전 NVIDIA 그래픽 카드 드라이버를 설치하는 것을 권장합니다. 최신 버전 PyTorch에서 최신 버전 CUDA를 요구하는 경우에 최신 버전의 NVIDIA 그래픽 카드 드라이버 설치가 필요하기 때문입니다. 특별한 경우를 제외하고는 CUDA를 따로 설치할 필요는 없습니다. Windows에 NVIDIA 그래픽 카드 드라..

문장의 유사도를 비교시 사용할 수 있는 Sentence Transformers 사용 방법을 다룹니다. 다음 문서를 기반으로 작성했습니다. Quickstarthttps://www.sbert.net/docs/quickstart.html#comparing-sentence-similarities 2024. 3. 2 최초작성2025. 1. 5 패키지 설치방법 보완테스트 해볼떄 기본 파이썬 환경과 독립적으로 패키지를 설치할 수 있는 Miniconda 사용을 추천합니다. Visual Studio Code와 Miniconda를 사용한 Python 개발 환경 만들기( Windows, Ubuntu)https://webnautes.tistory.com/1842 파이썬 가상환경을 생성후, sentence-transform..

괜찮은 파이토치 강좌를 찾아서 나름 다시 정리해본 결과를 공유합니다.최초작성 2024. 12. 10다음 포스트에 이어지는 내용입니다. 괜찮은 파이토치 강좌 - 01. 파이토치 기초https://webnautes.tistory.com/2409 괜찮은 파이토치 강좌 - 02. 파이토치 워크플로 살펴보기https://webnautes.tistory.com/2410다음 문서를 기반으로 작성되었습니다. 코랩에서 실행한 결과를 정리했습니다.https://www.learnpytorch.io/02_pytorch_classification/분류 문제(Classification)분류 문제는 주어진 대상이 미리 정해놓은 클래스 중에 어떤 것에 해당하는지 예측하는 문제입니다. 분류가 어떤 것인지 예를 들어보면 사진이 주어질..

괜찮은 파이토치 강좌를 찾아서 나름 다시 정리해본 결과를 공유합니다.최초작성 2024. 11. 24다음 포스트에 이어지는 내용입니다. 괜찮은 파이토치 강좌 - 01. 파이토치 기초https://webnautes.tistory.com/2409 다음 문서를 기반으로 작성되었습니다. 코랩에서 실행한 결과를 정리했습니다. https://www.learnpytorch.io/01_pytorch_workflow/1. 데이터 준비데이터를 학습 및 테스트 세트로 분할 2. 모델 구축파이토치 모델 구축 필수 요소파이토치 모델의 내용 확인하기torch.inference_mode()를 사용하여 예측하기 3. 학습 모델파이토치에서 손실 함수 및 옵티마이저 생성하기파이토치에서 최적화 루프 생성하기파이토치 학습(Training) ..

괜찮은 파이토치 강좌를 찾아서 나름 다시 정리해본 결과를 공유합니다.최초작성 2024. 11. 19다음 문서를 기반으로 작성되었습니다. 코랩에서 실행한 결과를 정리했습니다. https://www.learnpytorch.io/00_pytorch_fundamentals/ 1. PyTorch 코드 실행하기 2.텐서 소개 3.텐서 생성하기난수로 채워진 텐서 생성하기0 또는 1로 채워진 텐서 생성하기범위 값으로 채워진 텐서 생성하기다른 텐서와 크기가 동일한 텐서 생성하기 4.텐서 데이터 타입특정 데이터 타입의 텐서 생성하기 5.텐서 정보 얻기 6.텐서 조작하기기본 연산행렬 곱셈(Matrix multiplication)요소별 곱셈과 행렬 곱셈의 차이행렬곱셈과 신경망min, max, mean, sumPositio..

파이토치 튜토리얼의 quickstart를 번역했습니다.2024. 10. 21 최초작성2024. 10. 26 다음 문서를 기반으로 작성되었습니다.https://pytorch.org/tutorials/beginner/basics/quickstart_tutorial.html https://pytorch.org/tutorials/beginner/basics/transforms_tutorial.html https://pytorch.org/tutorials/beginner/basics/optimization_tutorial.html 데이터와 함께 작업하기파이토치(PyTorch)에는 데이터 작업을 위한 두 가지 핵심 요소가 있습니다. torch.utils.data.DataLoader와 torch.utils.dat..

크롬 확장 프로그램을 사용하여 이미지 검색에서 이미지를 수집(다운로드)하는 방법을 다룹니다. 2024. 10. 25 최초작성 https://youtu.be/nUzA-O0ix-E

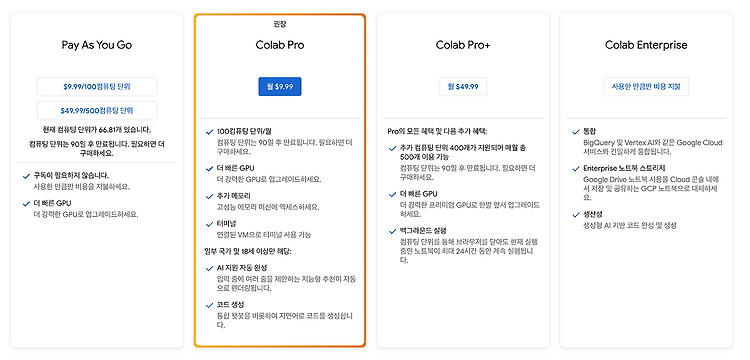

코랩을 사용해본 후기입니다. 2022. 11. 10 최초작성2024. 2. 172024. 6. 19 변경된 하드웨어 반영. 일부 사용률도 변경됨2024. 10. 5 런팟 포스트 링크 추가글 작성 시점에서(2024. 6. 18) Colab 요금제 입니다. Colab Pro를 구독하지 않고 필요할때마다 충전해서 사용하는 Pay As You Go를 사용하고 있습니다. 이 글을 처음 작성할때에는(2022. 11. 10) Colab Pro를 구독했었습니다. 코랩 프로의 경우엔 매달 9.99달러가 지불되며 컴퓨팅 단위 100개를 받습니다. 신용카드를 등록한 후, 컴퓨팅 단위 100개를 구입할 수 있습니다. 사용가능한 하드웨어 가속기 종류는 다음과 같습니다. 성능은 A100 GPU > L4 GPU > T4..