gemma 모델은 4가지가 공개되었으며 AutoModelForCausalLM와 AutoTokenizer를 사용해서 사용가능했습니다. 예제 코드는 모델 페이지에 있습니다.

7B base model https://huggingface.co/google/gemma-7b

2B base model https://huggingface.co/google/gemma-2b

7B instruct model https://huggingface.co/google/gemma-7b-it

2B instruct model https://huggingface.co/google/gemma-2b-it

2024. 2. 22 최초작성

2024. 2. 23 수정

2024. 2. 27

코랩에서 허깅페이스를 사용하여 gemma를 사용할 경우 허깅페이스 로그인 하거나 토큰 등록 후, 진행해도 에러가 나네요. 이때 허깅페이스 허브의 해당 젬마 페이지에 가보면 라이센스 동의를 하는 것이 보이는데 이걸 진행해주니 코랩에서 gemma를 다운로드하여 사용하는게 가능했습니다.

gemma가 공개된지 얼마 안되어 인지 아직 반영된 transformers 패키지 릴리즈 버전이 안나와서인지 사용시 다음 에러도 발생했습니다.

ValueError: Tokenizer class GemmaTokenizer does not exist or is not currently imported.

다음처럼 것허브 소스를 사용하여 transformers 패키지를 설치후.. 세션을 재시작해주면 문제없이 동작했습니다.!pip install git+https://github.com/huggingface/transformers

transformers 4.38.1을 지정하여 사용하니 transformers 패키지를 소스코드로 설치할 필요없어졌습니다. 코랩에서 pip 사용시 최신버전을 설치안해주는 경우도 있어서 이렇게 해야 하더군요.

!pip install transformers==4.38.1

런타임 연결을 다시하여 모델을 다시 다운로드하는 경우엔 AutoModelForCausalLM와 AutoTokenizer 코드 실행하기 전에 다음 코드에 토큰을 넣어서 실행해줘야 합니다. 파인튜닝 진행중에 체크포인트 저장하기 전에도 필요합니다.

토큰은 https://huggingface.co/settings/tokens에서 얻을 수 있습니다.

import os

os.environ["HF_TOKEN"] = '토큰'

파인튜닝된 모델을 다시 로드시에는 해줄 필요가 없었습니다.

참고

https://github.com/huggingface/transformers/issues/22222#issuecomment-1473886267

GitHub - huggingface/transformers: 🤗 Transformers: State-of-the-art Machine Learning for Pytorch, TensorFlow, and JAX.

🤗 Transformers: State-of-the-art Machine Learning for Pytorch, TensorFlow, and JAX. - huggingface/transformers

github.com

'Deep Learning & Machine Learning > Colab' 카테고리의 다른 글

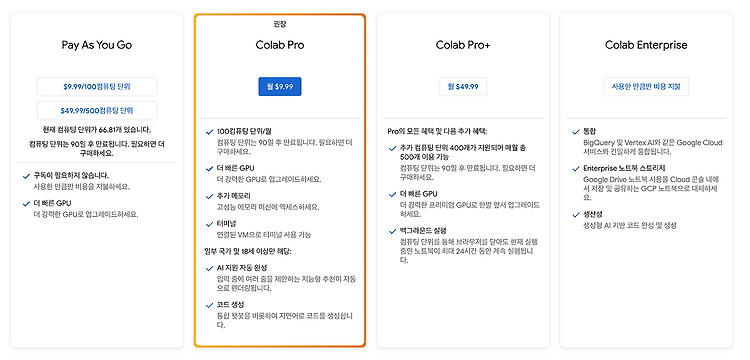

| 코랩 사용기 ( Pay As You GO, 코랩 프로) (3) | 2024.10.05 |

|---|---|

| 코랩 대안 런팟(RunPod) 사용방법 (8) | 2024.10.02 |

| The model 'OptimizedModule' is not supported for text-generation 해결방법 (0) | 2024.02.20 |

| NotImplementedError: A UTF-8 locale is required. Got ANSI_X3.4-1968 해결방법 (0) | 2024.02.19 |